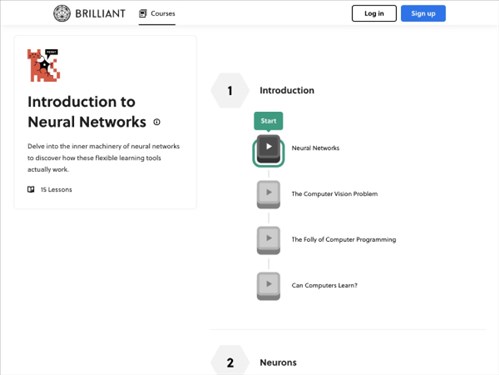

神经网络入门

神经网络概述

神经网络(Neural Network)是人工智能领域的重要技术,其灵感来源于生物神经系统中神经元的结构与功能。通过模拟神经元之间的连接与信息传递,神经网络能够从数据中自动学习复杂模式,实现分类、预测、生成等任务。作为机器学习的核心方法之一,神经网络在计算机视觉、自然语言处理等领域展现出强大的应用潜力。

---

基本结构与核心组件

神经网络由输入层、隐藏层和输出层构成,各层由神经元(节点)组成。

- 输入层:接收原始数据(如图像像素、文本特征)。

- 隐藏层:通过多层非线性变换提取数据的抽象特征。

- 输出层:生成最终结果(如分类标签、预测值)。

连接权重与偏置:

神经元之间通过权重(Weight)和偏置(Bias)连接,权重表示输入对输出的影响程度,偏置允许模型适应不同输入范围。

激活函数:

神经元的输出需经过激活函数(如ReLU、Sigmoid)引入非线性,使网络能拟合复杂函数。例如,ReLU函数(`f(x)=max(0,x)`)通过截断负值,加速训练并减少梯度消失问题。

---

技术原理与训练过程

神经网络的核心是前向传播与反向传播的迭代优化过程:

1. 前向传播:输入数据通过层间传递,结合权重与偏置计算输出。

2. 损失函数:衡量预测值与真实值的差异(如均方误差、交叉熵)。

3. 反向传播:通过梯度下降算法,从输出层向输入层反向调整权重与偏置,最小化损失函数。

训练目标是通过大量数据迭代,使网络参数(权重、偏置)收敛到最优解,从而提升对未知数据的泛化能力。

---

发展历程与里程碑

- 1940年代:McCulloch和Pitts提出首个人工神经元模型,奠定理论基础。

- 1950年代:Rosenblatt发明感知器(Perceptron),但受限于仅能解决线性可分问题。

- 1980年代:

- Rumelhart和Hinton等人提出反向传播算法,为多层网络训练提供数学支持。

- 首个深度网络(含多隐藏层)被提出,但受限于计算资源未广泛应用。

- 2012年:Hinton团队在ImageNet竞赛中使用深度卷积网络(AlexNet)取得突破,标志深度学习时代的开启。

- 2020年代:Transformer架构(如BERT、GPT)推动自然语言处理与生成式AI的革命。

---

典型应用场景

1. 图像识别:如人脸识别、医学影像分析。

2. 自然语言处理:机器翻译、情感分析、文本生成(如ChatGPT)。

3. 语音识别:智能助手(如Siri、Alexa)的语音转文本功能。

4. 强化学习:AlphaGo在围棋中的决策优化。

5. 工业控制:通过传感器数据预测设备故障(如文档2中提到的空调系统温度控制案例)。

---

挑战与未来趋势

当前神经网络面临计算成本高、可解释性差、数据依赖性强等问题。未来发展方向包括:

- 轻量化模型:如MobileNet、模型蒸馏,降低部署门槛。

- 自监督学习:减少对标注数据的依赖。

- 神经符号系统:结合深度学习与符号逻辑,提升可解释性。

- 量子神经网络:探索量子计算与神经网络的融合,突破算力瓶颈。

神经网络作为AI领域的基石技术,其持续演进将推动更多领域的智能化变革。

应用截图