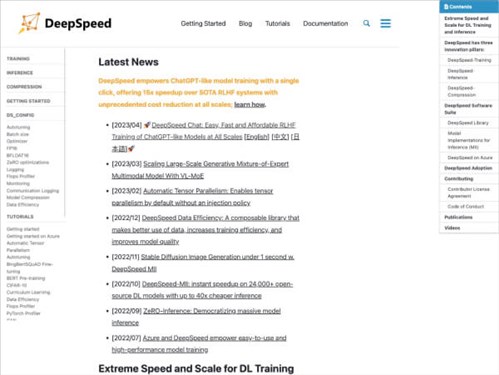

DeepSpeed

概述

DeepSpeed 是由微软(Microsoft)开发的开源深度学习优化库,专为大规模模型的高效训练和推理设计。其核心目标是通过系统级优化技术降低大规模模型的开发门槛,提升训练和推理的效率。DeepSpeed 支持 PyTorch 框架,适用于自然语言处理(NLP)、计算机视觉等领域的复杂模型,如 GPT 系列、BERT、Mixtral、Phi-2 等。自 2019 年首次发布以来,它已成为工业界和学术界广泛采用的工具,显著推动了超大规模模型的落地应用。

发展历程

- 2019年:DeepSpeed 首次发布,提出多项创新技术,包括 ZeRO(Zero-Redundancy Optimization)优化算法,通过减少显存占用和通信开销,实现了大规模模型的分布式训练。

- 2020年:引入 DeepSpeed-Engine,整合训练优化与推理加速功能,并支持混合精度训练(如 FP16、BF16)。

- 2021年:推出 DeepSpeed-Inference,专注于推理阶段的性能优化,通过稀疏化、量化等技术减少计算资源消耗。

- 2023年:发布 DeepSpeed-RLHF,专为强化学习与人类反馈(RLHF)流程设计,简化对话模型的训练与推理切换流程。

- 2024年:推出 DeepSpeed-FastGen,新增对 Mixtral、Phi-2、Falcon 等开源大模型的支持,显著提升生成速度与能效比(@documents@[2])。

技术特点

1. 训练优化技术

- 动态微调(Dynamic Finetuning):自动调整训练参数,适应不同规模的模型和硬件配置(@documents@[1])。

- 混合精度训练:通过 FP16/BF16 精度混合,平衡计算速度与精度,降低显存占用。

- 内存优化:采用 ZeRO 系列算法(如 ZeRO-3、ZeRO-Offload),减少参数冗余和梯度同步开销,支持万亿级参数模型训练。

2. 推理加速技术

- DeepSpeed-FastGen:通过模型压缩(如稀疏化、量化)和并行推理优化,将生成速度提升数倍。例如,Phi-2 模型在 16 位量化下推理速度可提升 4-6 倍(@documents@[2])。

- 动态批处理(Dynamic Batching):根据实时负载动态调整推理批处理大小,提升硬件利用率。

3. 强化学习与对话模型支持

- DeepSpeed-RLHF:提供端到端的 RLHF 流程支持,允许模型在训练和推理模式间无缝切换,降低对话模型开发复杂度(@documents@[3])。

应用场景

- 大规模模型训练:如 Meta 的 Llama 系列、Mistral AI 的 Mixtral 等开源模型均采用 DeepSpeed 进行训练加速。

- 工业级推理部署:腾讯等企业利用 DeepSpeed-FastGen 在服务器端实现高并发推理,例如对话系统、代码生成等场景(@documents@[5])。

- 学术研究:DeepSpeed 的开源特性使其成为研究大规模模型效率优化的首选工具,支持多模态和跨领域模型实验。

市场影响

- 降低算力门槛:通过优化技术,开发者可在中等规模硬件上训练百亿级参数模型,推动开源大模型生态发展。

- 加速商业化落地:在 AIGC(人工智能生成内容)、客服对话机器人等领域,DeepSpeed 的推理优化显著降低部署成本。

- 开源社区贡献:GitHub 上累计数千星标,成为 PyTorch 生态的重要补充,促进算法创新与工程实践的结合。

未来展望

DeepSpeed 的持续演进方向包括:

1. 多技术融合:结合模型压缩、神经架构搜索(NAS)等技术,进一步提升能效比。

2. 跨框架支持:扩展对 TensorFlow 等框架的兼容性,扩大适用范围。

3. 量子计算适配:探索与量子计算硬件的结合,应对未来超大规模模型的训练需求。

截至 2025 年,DeepSpeed 已成为人工智能领域基础设施的关键组件,其技术路线图持续推动着大模型从实验室走向实际应用。

应用截图