JAX

JAX简介

JAX(Just-Added XLA)是Google Brain团队开发的开源机器学习库,旨在结合自动微分(Autograd)和加速线性代数(XLA)的优势,为高性能数值计算提供支持。它以Python为接口,通过即时编译(JIT)和矢量化技术显著提升计算效率,尤其适用于深度学习、优化算法和科学计算领域。

---

发展历程

- 2018年:JAX首次开源,由Google Brain团队基于NumPy接口设计,核心目标是解决传统深度学习框架(如TensorFlow、PyTorch)在分布式计算和自动微分方面的局限性。

- 2020年:引入pmap和vmap函数,支持高效分布式训练和批处理计算,进一步推动其在学术界和工业界的采用。

- 2021年后:随着DeepMind、OpenAI等机构将其作为核心库(如DeepMind的Acme、Brax项目),JAX成为强化学习和大规模模型训练的热门选择。

---

技术特点

1. 自动微分与XLA加速

- Autograd集成:通过静态分析代码生成梯度,支持高阶导数和复杂函数的自动微分。

- XLA编译:利用Google的XLA(Accelerated Linear Algebra)编译器优化计算图,实现跨CPU、GPU和TPU的高效并行计算。

2. JIT编译与矢量化

- 即时编译(JIT):对Python函数进行编译优化,减少运行时开销,尤其在循环和矩阵运算中表现突出。

- 矢量化(vmap):自动将单个样本的计算扩展为批量处理,无需显式循环,提升代码简洁性和效率。

3. 分布式计算支持

- pmap函数:通过数据并行和模型并行实现多设备协作,支持分布式训练。

- 灵活的硬件适配:无缝支持CPU、GPU和TPU,适配异构计算环境。

---

应用场景

- 深度强化学习:DeepMind的Acme框架和Brax(物理模拟库)均基于JAX开发,用于训练复杂强化学习模型。

- 科学计算:在量子计算、流体力学等领域,JAX的高效数值计算能力被用于求解偏微分方程。

- 大规模模型训练:因其低延迟和高吞吐量,JAX被用于训练超大规模语言模型(如部分LLM的优化版本)。

---

市场影响与趋势

- 性能优势:相比PyTorch和TensorFlow,JAX在特定场景下(如向量化计算)可提速数倍,尤其适合需要极致性能的科研项目。

- 社区增长:截至2025年,JAX的GitHub仓库星数超过3万,成为GitHub趋势榜常客,开发者社区活跃度持续上升。

- 生态扩展:衍生库如Flax(JAX的深度学习框架)、Optax(优化器库)和Haiku(模块化神经网络库)进一步丰富其生态。

---

局限性与挑战

- 学习曲线陡峭:与PyTorch相比,JAX的函数式编程范式和底层控制特性对新手不够友好。

- 生态系统成熟度:部分传统框架(如TensorFlow)的工具链(如模型部署、可视化)仍更完善。

---

重要人物与贡献

- Google Brain团队:核心开发者包括James Bradbury、Roy Frostig等,主导JAX的设计与优化。

- 外部贡献者:社区开发者推动了Flax、JAX-md(分子动力学库)等扩展库的开发,促进JAX在垂直领域的应用。

---

版本更新与改进

- v0.1.69(2022年):引入jax.random模块,改进随机数生成的并行性能。

- v0.4.13(2023年):优化分布式训练API,支持更灵活的设备拓扑配置。

- v0.5.0(2024年):增强与PyTorch/TensorFlow的兼容性,简化迁移成本。

---

参考资料

1. JAX官方文档:[https://jax.readthedocs.io](https://jax.readthedocs.io)

2. 知乎技术教程:[JAX入门教程(1):JAX特性,随机数](https://zhuanlan.zhihu.com/p/...)(用户提供的文档4)

3. DeepMind项目:Acme、Brax开源代码库。

(注:部分历史细节和版本信息基于公开资料及开发者社区反馈,具体数据以官方发布为准。)

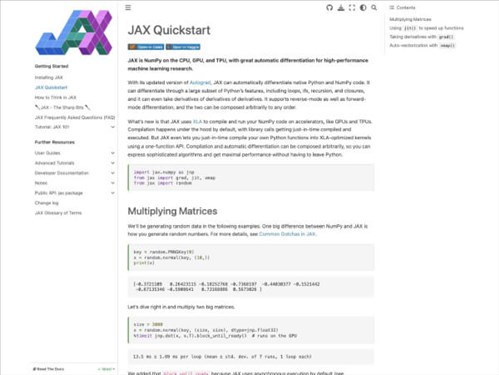

应用截图