Riffusion

简介

Riffusion是由Seth Forsgren和Hayk Martiros于2022年联合开发的开源AI音乐生成系统。该项目旨在通过深度学习技术实现实时音乐创作,允许用户基于文本描述、音乐概念或现有片段生成原创音乐。作为开源项目,Riffusion为音乐创作者和AI研究者提供了灵活的工具,并在音乐生成领域引入了创新方法(资料来源:文档2、4)。

功能与技术特点

核心功能:

- 文本到音乐生成:用户可通过输入自然语言描述(如“80年代电子摇滚节奏”)生成对应风格的音乐片段。

- 实时交互式创作:支持动态调整音乐参数(如节奏、旋律、和声),实现即时反馈。

- 风格迁移与融合:能够混合不同音乐流派或艺术家的风格,生成独特作品。

技术基础:

Riffusion基于稳定扩散算法(Stable Diffusion),该算法最初在图像生成领域取得成功,后被迁移至音乐领域。其模型架构结合了深度学习生成网络与条件控制机制,通过训练大量音乐数据集学习风格特征,并利用扩散过程逐步生成音乐波形(资料来源:文档4、5)。

开源特性:

作为开源项目,Riffusion的代码库和模型权重公开于GitHub等平台,促进社区协作改进。开发者可通过扩展模型、优化算法或开发插件进一步提升系统能力(资料来源:文档2、4)。

发展历程

- 2022年:Seth Forsgren与Hayk Martiros启动项目,首次公开Riffusion的概念与原型。

- 关键里程碑:

- 开源发布:项目代码与文档在GitHub上线,吸引开发者与音乐创作者参与测试与改进。

- 模型迭代:推出riffusion-model-v1版本,优化生成质量与时延,支持多乐器协同生成(资料来源:文档5)。

- 社区贡献:通过用户反馈持续优化,例如增加对不同音乐格式(如MIDI、WAV)的支持。

应用场景与影响

应用场景:

1. 音乐创作辅助:帮助创作者快速生成灵感,或生成背景音乐、音效。

2. 教育与实验:音乐教育者可利用Riffusion演示不同风格的音乐结构,学生可通过实验性生成探索创作边界。

3. 跨领域融合:与游戏、影视行业结合,自动生成适配场景的音乐片段。

市场与行业影响:

- 降低创作门槛:非专业用户可通过文本描述生成音乐,推动音乐创作民主化。

- 激发创新:开源模式加速了AI音乐技术的迭代,例如衍生出结合视觉与音乐生成的多模态项目。

- 挑战与争议:版权问题(如生成内容的原创性)及算法偏见(如风格代表性不足)引发行业讨论(资料来源:文档1、4)。

技术局限与未来方向

当前局限:

- 生成质量依赖数据:模型输出可能受限于训练数据的多样性和质量。

- 实时性与复杂度权衡:高复杂度编曲可能牺牲生成速度。

未来趋势:

- 多模态整合:结合视觉、情感分析等技术,实现更精准的音乐生成(如根据视频内容自动生成配乐)。

- 个性化定制:通过用户偏好学习,提供高度个性化的创作建议。

- 伦理与版权框架:探索生成内容的版权归属机制,确保技术合规性(资料来源:文档5)。

开发者与社区

核心团队:

- Seth Forsgren:项目发起人之一,专注于AI与音乐的交叉研究。

- Hayk Martiros:技术负责人,主导模型架构设计与算法优化。

社区生态:

Riffusion的GitHub仓库与论坛汇聚了全球开发者与音乐爱好者,形成了从代码贡献到音乐作品分享的活跃社区。例如,用户通过插件扩展了对古典音乐和民族乐器的支持(资料来源:文档2、4)。

小编建议

Riffusion凭借其开源特性、创新算法与直观的交互设计,成为AI音乐生成领域的标杆项目。它不仅为创作者提供了强大的工具,还推动了音乐技术的开放协作模式。未来,随着算法优化与跨领域融合,Riffusion有望进一步重塑音乐创作与消费的边界。

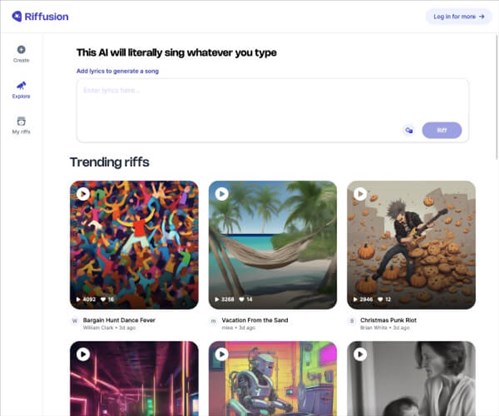

应用截图